ИИ уже внедрен в нашу реальность, и мы понимаем, что без него уже не обойтись. Он «подсовывает» нам ролики, помогает врачам находить редкие заболевания, а интернет-магазинам — советовать товары. Все это замечательно, пока не начинаешь замечать, что любая мощная технология имеет свои минусы и риски для пользователей в целом.

Искусственный интеллект сравним с энергией атома. И то, и другое можно применять и в мирных, и в военных целях. Все понимают, что ядерная бомба — разрушительная вещь. Искусственный интеллект тоже может быть разрушительным.

Во-первых, ИИ может создавать различные дипфейки и другой контент, где практически невозможно отличить правду от лжи.

Во-вторых, ИИ может неправильно отслеживать, например, систему логистики из-за ошибок в данных, сложностей внедрения технологий или проблем с интеграцией с существующими системами.

В-третьих, искусственный интеллект может генерировать данные с ошибками, а человек — принимать эту информацию за истину. Это проблема данных, на которых его обучают: программа будет генерировать контент с различными искажениями.

ОСНОВНЫЕ МИНУСЫ ВНЕДРЕНИЯ ИИ

Безопасность

Самая первая реальность, с которой столкнулись пользователи, — это безопасность персональных данных. Компании, которые внедряют ИИ, получают всю информацию о клиентах или пользователях. С одной стороны, это удобно, когда сервису видно, какими товарами интересовался пользователь, и он предлагает в первую очередь именно их или скидки на эту продукцию. С другой стороны, то, насколько глубоко алгоритмы могут проникать в личную жизнь и персонализацию, — это страшно. Геолокация, покупки, переписка, голосовые сообщения — любая деталь может стать «кормом» для ИИ. И, к сожалению, безопасность не всегда успевает за теми, кто хочет эти данные украсть или использовать в нечестных целях. В итоге имеем угрозу нарушения приватности и конфиденциальности персональных данных, которые могут попасть в нечестные руки или утечь в глобальную сеть.

Угроза кибератак и некорректная работа

Злоумышленники тренируют свою модель на распознавании уязвимостей компьютерных систем. Алгоритм подбирает оптимальный способ «взлома», перебирает сотни вариантов и находит брешь, о которой даже специалисты не догадываются. Когда такой «умный» помощник используется знания во вред, ущерб может быть колоссальным: утечка информации (финансового характера и рабочих моментов для конкурентов).

«Программа выдала сбой!» — это рядовая фраза, с которой мы сталкиваемся в быту: «компьютер завис», «телефон не открыл приложение». Но в случае с огромными нейросетями непонятно, где именно допущен сбой. Это делает использование ИИ в ответственных сферах (медицина, транспорт, финансы) потенциально опасным, если не предусмотреть системы контроля и многократной проверки результатов.

Потеря рабочих мест

Достаточно внедрить автоматизированную линию, «начиненную» умными алгоритмами, и весь процесс (упаковка, проверка на брак, даже складирование) происходит без участия человека. ИИ действительно автоматизирует труд, но не всегда человек может переквалифицироваться, чтобы найти себе новое место работы. Целые профессии вымирают. Да, вместе с этим появляются новые специальности: обучение нейросетей, аналитики данных и прочие, но «технический разрыв» между теми, кто успел «запрыгнуть» в этот прогресс, и отставшими может оказаться колоссальным.

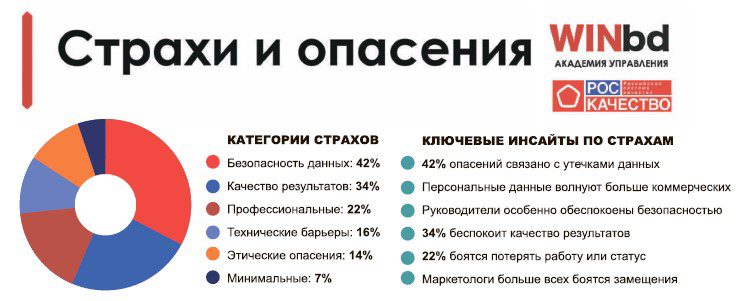

Особенно маркетологи боятся потерять работу — ведь это та специальность, в которую в наибольшей степени внедряется ИИ.

Морально-этические нормы

Люди проводят все больше времени с нейросетями: по результатам опроса исследовательской компании Pew Research Center, 27% взрослых жителей США взаимодействуют с искусственным интеллектом несколько раз в день, а еще 28% — как минимум несколько раз в неделю. Такая тесная связь приводит к «близким» отношениям с чат-ботами и влюбленности в роботов. Обратная сторона явления — тоска, страх, тревога, а в некоторых случаях обострение ментальных расстройств и потеря связи с реальностью.

Люди сходят с ума: верят, что за ними следят, все больше людей после общения с нейросетями начинают сходить с ума. Существуют примеры, когда ChatGPT убеждал пользователей, что против них ведутся заговоры, а у других подпитывал на бредовые идеи, провоцировал принимать неправильные решения и даже подталкивал к суициду.

Искажение данных

Все данные, которые мы получаем с помощью искусственного интеллекта, запрограммированы людьми. Насколько компетентны эти люди, разбираются ли они в вопросах, откуда пришли эти данные, насколько правильно они отражены, и кто заказчик? Эти проблемы — проблемы ИИ.

Например, если изначально данные были некорректны или отражали человеческие предубеждения (например, при найме сотрудников), то алгоритм будет бездумно «зеркалить» их, отсекая тех, кто действительно достоин вакансии.

Цифровая зависимость

ИИ подсказывают нам, какие фильмы смотреть, где отдыхать, в какой компании работать, на какие группы подписаться. Этот «комфорт» превращается в цифровую зависимость. Мы перестаем учиться думать сами. Самый видимый пример — это использование навигатора и калькулятора.

Неравномерность распределения ИИ

Мощные инфраструктуры, суперкомпьютеры и самые передовые разработки сосредоточены в основном в руках крупных корпораций и развитых стран. А в бедных странах уровень цифровизации может сильно отставать.

ПРЕОДОЛЕНИЕ СТРАХОВ

Чтобы убрать страхи в использовании ИИ, надо прежде всего научиться правильно пользоваться этими программами и правильно распределять роли ИИ и человека.

Снизить страхи перед искусственным интеллектом (ИИ) можно, сочетая образование, коммуникацию, психологические техники и учет этических норм. Ведь, исходя из данных статистики, знание функций ИИ и умение ими правильно пользоваться существенно снижает страхи перед ним.

Обучение. Понимание алгоритмов и функций различных типов ИИ (нейронные сети, машинное обучение, глубокое обучение) позволит осознанно оценивать его возможности и ограничения. Нужно читать книги, статьи и смотреть документальные фильмы на тему ИИ. Общественные нормы и этика ИИ формируются через образование и медиа, опыт использования продуктов ИИ, публичные дискуссии и гражданское участие. Чем лучше понимание, как работают их системы и продукты, тем быстрее формируется доверие.

Анализировать реальные кейсы. Изучение примеров успешного применения ИИ в различных отраслях демонстрируют его практическую пользу.

Развивать критическое мышление. Необходимо анализировать информацию, отделять факты от мифов и манипуляций. Это поможет лучше ориентироваться в информации, предоставленной ИИ.

Ограничить пугающий контент. Если после новостей про ИИ портится настроение, стоит сократить потребление таких материалов. Страх подпитывается негативным информационным фоном.

ВЫВОД:

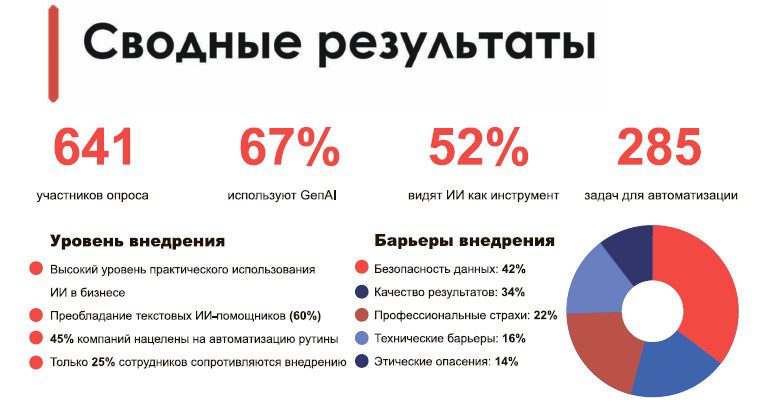

Из всего перечисленного можно сделать вывод, что компании, которые хотят идти в ногу со временем, все же внедряют ИИ в свой бизнес, хотя 25% сотрудников сопротивляются использованию ИИ в работе. И 45% компаний уверены, что с помощью ИИ можно преодолеть рутинные работы.

Самый главный страх — это незнание инструмента ИИ. Преодоление этих страхов, обучение и правильное применение функций ИИ, не забывая о человеческом факторе, — главные инструменты применения возможностей искусственного интеллекта.

Использованы материалы

www.securitylab.ru

www.trends.rbc.ru